中国与美国要兑现token经济学,都需要用电力来破题。两国情况各有不同。美国的问题在于缺电,发电与电网基础设施落后,token产出规模受限于电力规模;中国的问题在于用电力换算力,相对低能效的硬件,推高了token单位成本。

在上周的采访中,微软CEO纳德拉(Satya Nadella)认为,现在与其说是缺卡,不如说是缺电,电力与就近数据中心的建设速度,限制了token的产出与变现。电不到位,通电的建筑(Warm Shell)不到位,GPU再多也只能躺着吃灰。

美国巨头之间新一轮AI基础设施投资高潮,已经变成了一场电力竞赛。扎克伯格也说,如果能获得能源,Meta就可以建立比现在更大的集群。它们的电或者来自公共电网,或者自建表后电力(behind-the-meter),或者两者结合。但每一项都不简单。尤其是ChatGPT智能体,正养出百万卡算力巨兽。美国的数据中心,正在从1GW级稳步迈向10GW级。Crusoe就声称,目前正在建设中的怀俄明州单一数据中心,一期目标1.8GW,远期目标10GW。

目前巨头自建离网电力,迄今还没有达到1GW级别的。它涉及到大规模天然气管道等基础设施的建设与燃气轮机的部署。但是,即使电力主要来自公共电网,在电力规模不断扩展的趋势下,同样困难重重。

研究机构EpochAI分析称,因为市场时不时担心AI泡沫,出于对需求方“跑路”的担心,美国的公用事业公司,通常不愿签署非常大的购电协议,也不愿对输电基础设施进行相应的资本投资。当然,OpenAI的奥特曼估计也不愿意亲自和电力签长约,上周他就说,“如果极廉价能源在短期内大规模上线,很多人会被自己签过的长约反噬”。

还有一个重要原因在于,数据中心规模与负荷越来越大,将对老旧的电网带去风险。美国最大的公用事业公司NextEra的首席执行官John Ketchum就称,支撑1GW需求相对容易,但要容纳5GW需要“一些工作”,更不用说10GW了。而且,即使美国最高容量的765kV双回路电压走廊,长距离也只能承载6-7GW容量规模的数据中心。

硅谷巨头已经多次向白宫喊话,索要产业政策的支持。面对白宫征询AI行动计划(AI Action Plan)意见,谷歌第一条建议就是基础设施,主要是电力系统。谷歌已经看到,创新需要迫切地从芯片(Chip)转向电网(Grid)了。此后,白宫也确实将“发展与人工智能创新速度相匹配的电网”,写入了“建设美国AI基础设施”这一章节,包括探索利用现有承载量的创新方法,优先考虑可靠、可调度电源的互联,并拥抱技术前沿的新能源发电来源。

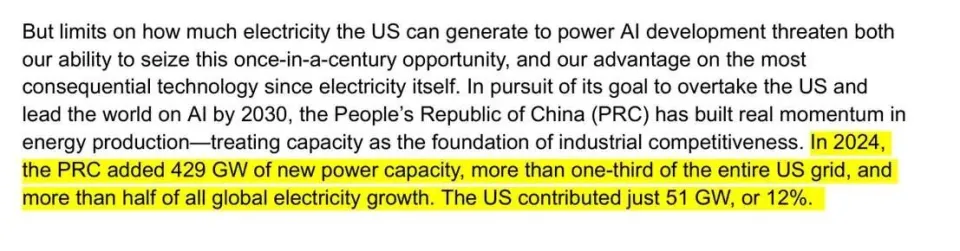

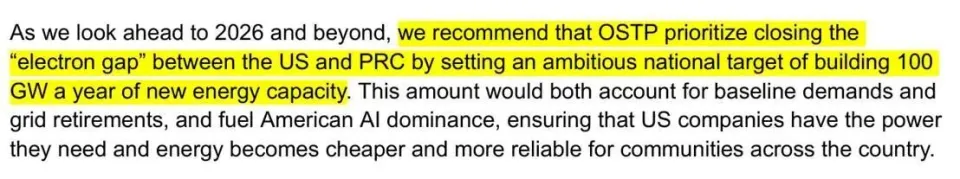

上周,OpenAI继续向白宫建言,要和中国在AI上竞争,美国必须每年新增100GW的电力容量。去年,美国新增装机51GW,中国新增429GW,“电力鸿沟”巨大。

中国的发电量是美国的两倍多,电网比美国更加“坚强”,但是,中国的AI基础设施也有自己的“电力”难题。它建立在国产芯片的基座之上,后者在能效等方面仍然处于劣势。随着多模态模型与智能体协作的渗透,中国巨头对于算力的需求,向百万张卡级别迈进也是时间问题,低能效的短板会进一步放大。字节跳动的日均token调用,从今年5月的16.4万亿攀升至9月的30万亿,4个月翻了一倍。

在token经济学中,token成本是相当重要的组成部分。对于市场化的互联网巨头而言,token的成本就是AI基础设施的竞争,既包括硬件之上的软件与工具,也包括硬件本身,当然还包括让这些软硬件运行起来的电力与冷却系统。

长期而言,缺芯片的中国,正在举国攻关芯片和计算效率的突破。最重要的长期战略之一,就是维护国产算力生态健康有序地竞争与创新。在产业方面,DeepSeek等开源模型厂商正在牵引着芯片厂商软硬件协同设计;在资本方面,A股也在加速迎接摩尔线程与沐曦股份上市,壁仞科技、砺算科技与燧原科技也在推进中;在政策方面,国家也出台多项政策鼓励数据中心使用国产芯片,尤其是央企与政务相关。

这意味着,如果互联网巨头为长期战略选择国产芯片,也就在短期内承担了国产芯片用电力换算力的相对成本。在国内,一个主流云厂商,1GW的全年电费,大概在80-90亿元。

上半年,华为CloudMatrix 384发布,被视为用电力换算力的典型。相比当时英伟达最新推出的GB200 NVL72,它差不多在总算力上提升了1.7倍,但全系统能耗相应提高了3.9倍。为方便比较,不考虑单位内存或单位带宽的能耗,仅比较单位算力性能,那么,GB200 NVL72的约为0.81pJ(皮焦耳)/ FLOP,而CloudMatrix 384约为1.87pJ/ FLOP。相当于,超节点每执行需要1个FLOP的算力的任务,CloudMatrix 384就要比GB200 NVL72多消耗130%的电力。

下半年,华为在全联接大会上展示了昇腾AI芯片4年5款产品的路线图,以及更强大的Atlas 950 SuperPoD和Atlas 960 SuperPoD超节点,在卡规模、总算力、内存容量、互联带宽等关键指标上全面领先,不过没有披露最新的能效数据。考虑到在中国先进制程等半导体设计与制造领域,尚未追平全球最领先的水平,单位能效的差距在短期内也无法迅速抹平。

补贴等产业政策仍然可以与支持国产算力生态形成组合拳。甘肃、贵州和内蒙古等省份的工业电力单位成本,比中国东部更发达的沿海地区低约 30%,随着算力枢纽补贴采用国产芯片的数据中心,电价已经降至每度电4毛钱(5.6美分/kWh)以下甚至更低;而根据美国能源信息署8月份发布的数据,美国工业电力平均成本约为9.1美分/kWh。这相当于,中国AI生态每执行需要1个FLOP的算力的任务,花费的电费相当于美国AI生态的140%。这还没算上更低能效带来的更大的散热用电需求。

但是,一旦中国与美国的AI竞争扩展到全球,相应的补贴优势就会削弱。这就得进一步依靠模型效率与芯片能效的提升,以及新能源与储能出海的配合了。